Błędy w przypisywaniu dzieci do wrocławskich żłobków, nieprzejrzyste kryteria naboru studentów we Francji, kłopoty z alokacją włoskich wykładowców czy niezgodne z prawem decyzje dotyczące kariery nauczycieli w USA. To tylko kilka przykładów tego, jak algorytmy mogą wpływać na naszą edukację. Właśnie ukazał się raport o tym, co robić, aby to algorytmy służyły społeczeństwu, a nie na odwrót. Opracowanie przygotowali eksperci fundacji Centrum Cyfrowe i Klubu Jagiellońskiego.

Mamy jeszcze szansę, aby nie stracić wpływu na to, jak algorytmy będą nas oceniać w obszarze edukacji – mówi dr Alek Tarkowski, prezes fundacji Centrum Cyfrowe.

Zdaniem autorów raportu, którzy przeanalizowali przykłady wdrożeń oraz wniosków organizacji monitorujących skutki stosowania zautomatyzowanego podejmowania decyzji, nie musimy popełnić błędów, które już miały miejsce na Zachodzie. Eksperci wymieniają cztery przykłady z Polski i zagranicy, aby pokazać, jakie skutki może mieć utrata kontroli nad sztuczną inteligencją w obszarze edukacji.

Wrocław: błędy w przypisywaniu dzieci do żłobków

W 2018 roku we Wrocławiu głośno było o systemie przypisywania dzieci do żłobków. Źle zaprogramowany algorytm sprawił, że do placówki nie dostały się wtedy dzieci, którym przysługiwało miejsce. Ze względu na brak informacji o działaniu systemu rodzice zarzucali mu nieprzejrzyste i krzywdzące podejmowanie decyzji w sytuacji, gdy liczba żłobków była niewystarczająca. Platforma Zarządzania Oświatą stworzona przez Asseco Data Systems jest wykorzystywana przez 4,5 tys. szkół w 20 polskich miastach. Jednak całościowe dane o wykorzystaniu systemów automatycznego podejmowania decyzji w przypadku alokacji dzieci i młodzieży do placówek oświatowych do tej pory nie są znane.

Francja: nieprzejrzyste kryteria naboru studentów

W 2018 r. rząd francuski przyspieszył reformę, zgodnie z którą uniwersytety zaczęły mieć prawo do odrzucenia wniosków o przyjęcie na studia od potencjalnych studentów. Reforma została wprowadzona wraz z uruchomieniem internetowego narzędzia o nazwie Parcoursup, które przypisywało studentów do wolnych miejsc na uczelniach. Zadaniem platformy było łączenie życzenia studentów co do wymarzonej uczelni z dostępnymi ofertami. Parcoursup jest krytykowany za nieprzejrzystość procesu decyzyjnego - użytkownicy systemu nie są informowani, że decyzje są podejmowane automatycznie, a rząd opublikował jedynie kod samej platformy, a nie algorytmu. Uważa się, że system wykorzystuje dane osobowe, aby pomóc uniwersytetom w wyborze studentów, którzy najlepiej pasują do określonych kierunków studiów.

Włochy: błędy w alokacji wykładowców

We Włoszech, w ramach reform edukacyjnych „Buona Scuola” wprowadzono zautomatyzowany system zarządzania mobilnością wykładowców akademickich między uniwersytetami. System miał traktować priorytetowo wyniki oceny nauczycieli - im wyższy wynik, tym jego preferencje dotyczące wolnych miejsc pracy w konkretnej placówce miały być traktowane priorytetowo. Zamiast tego algorytm dawał pierwszeństwo jedynie preferencjom nauczycieli, bez uwzględnienia wyników. Wielu z nich skończyło w miejscach, które nie były nawet na ich liście. W efekcie przeprowadzono kontrolę algorytmu na uniwersytetach La Sapienza oraz Tor Vergata. Autorzy raportu z kolei stwierdzili, że algorytm ten nie powinien łączyć nauczycieli z ich docelowymi miejscami pracy, gdyż był po prostu źle napisany.

Stany Zjednoczone: niezgodne z prawem decyzje dotyczące kariery nauczycieli

Federacja Nauczycieli w Houston pozwała władze lokalne za wykorzystywanie danych z testów uczniów w automatycznym systemie podejmowania decyzji o zatrudnieniu nauczycieli i ich awansie. Władze miejskie twierdziły, że nie są w stanie wyjaśnić decyzji algorytmu kwestionującym ją nauczycielom, bo algorytm działa na zasadzie “czarnej skrzynki” (“black box”). Nauczyciele wnieśli więc pozew zarzucając naruszenie przepisów konstytucyjnych, praw obywatelskich i prawa pracy, a dostawca systemu nawet w trakcie procesu odmawiał zaprezentowania algorytmu. W efekcie sąd orzekł, że korzystanie z takich systemów w sferze publicznej narusza prawo do sprawiedliwego procesu i wyjaśnionej, klarownej decyzji.

Czy staniemy się ofiarami zautomatyzowanych decyzji?

W wyniku wprowadzenia sztucznej inteligencji obywatele zostają pozbawieni wiedzy o tym, według jakich kryteriów technologie cyfrowe podejmują o nich decyzje. Zdarza się również, że niesprawiedliwa decyzja bywa wynikiem wadliwie skonstruowanego algorytmu – przekonuje dr Alek Tarkowski.

Jego zdaniem, tego dałoby się uniknąć, gdybyśmy mieli wgląd w zautomatyzowane procesy decyzyjne podejmowane przez sztuczną inteligencję. Moglibyśmy zweryfikować to, czy są sprawiedliwe. - Doświadczenia z innych krajów pokazują, że obywatele stają się ofiarami zautomatyzowanych procesów decyzyjnych, które prowadzą także do pogłębiania nierówności społecznych, nasilają rasizm czy mogą pogłębiać ubóstwo – dodaje Tarkowski.

Szanse i zagrożenia zautomatyzowanego sposobu podejmowania decyzji dla Polski

Autorzy raportu opisują dwie strony medalu, wskazując zarówno korzyści, jakie nasz kraj będzie mieć z wdrożenia technologii cyfrowych na masową skalę, jak i wyzwania.

Jako kraj będziemy bardziej efektywni pod każdym względem, nasze decyzje będą bazować wyłącznie na danych i wiedzy, nie na emocjach, wyeliminujemy ludzkie błędy, w tym, przykładowo, stronniczość – wylicza Bartosz Paszcza z Klubu Jagiellońskiego, współautor raportu. – Z drugiej strony możemy stracić kontrolę nad współpracą z komputerami, sprawiedliwością i przejrzystością tego, co się dzieje w naszym życiu, nie mówiąc o utracie prywatności. Jeśli oddamy proces decyzyjny algorytmom, zatracimy też naszą kulturę na rzecz globalnych wzorców. Podsumowując – oddamy odpowiedzialność w ręce algorytmów.

O raporcie

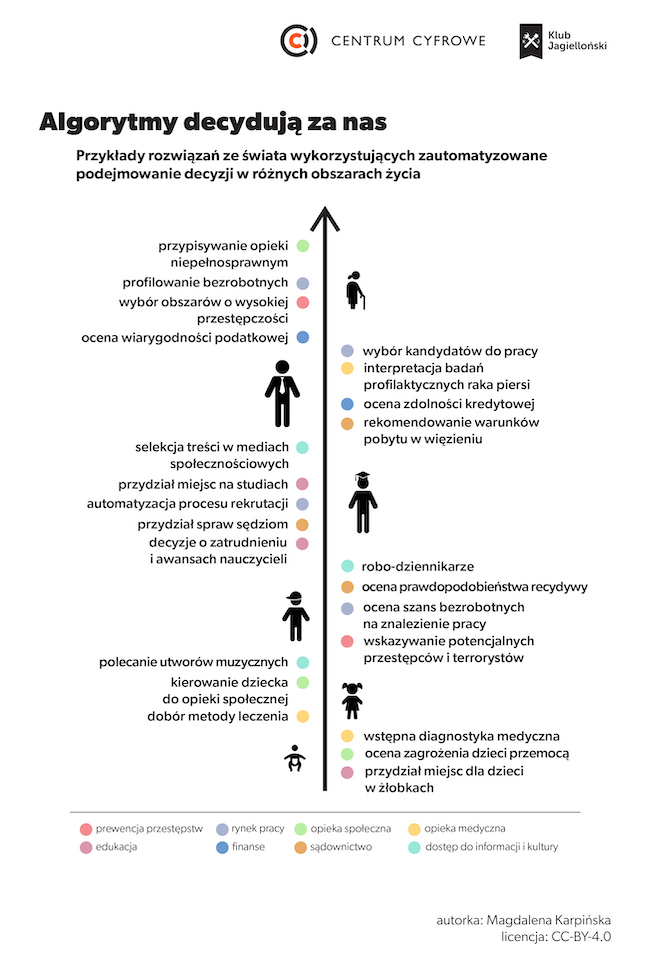

Raport pt. „Zautomatyzowane podejmowanie decyzji w służbie społeczeństwu” został przygotowany przez ekspertów fundacji Centrum Cyfrowe i Klubu Jagiellońskiego. Prezentuje przykłady na to, jak algorytmy podejmują decyzje za ludzi w kluczowych obszarach: prewencji przestępstw, rynku pracy, opiece społecznej i medycznej, edukacji, dostępie do kultury i informacji, finansach i sądownictwie. Autorzy uwzględnili przykłady z Polski i z zagranicy. Zaznaczają, że opracowanie nie jest kompleksowym źródłem przykładów zastosowania sztucznej inteligencji, a ich selekcją, która pomoże zrozumieć skalę stojącego przed nami wyzwania. Raport zawiera też rekomendacje, jak rozwijać w Polsce, w sposób zrównoważony, systemy automatycznego podejmowania decyzji.

Cały raport jest dostępny pod linkiem: https://centrumcyfrowe.pl/algopolska-raport/

(Źródło: Centrum Cyfrowe)